we find that the secret to Buffett’s success is his preference for cheap, safe, high-quality stocks combined with his consistent use of leverage to magnify returns while surviving the inevitable large absolute and relative drawdowns this entails.

Eles discutem se o sucesso do Buffet é sorte ou habilidade e chegam a conclusão que:

Our findings suggest that Buffett’s success is not luck or chance, but reward for a successful implementation of exposure to factors that have historically produced high returns.At the same time, Buffett’s success shows that the high returns of these academic factors are not just “paper returns”, but these returns could be realized in the real world after transaction costs and funding costs, at least by Warren Buffett.

Resumo:

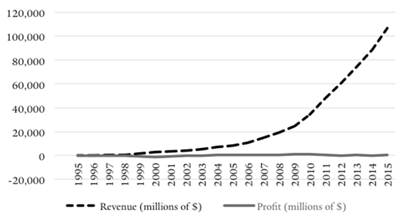

Berkshire Hathaway has realized a Sharpe ratio of 0.76, higher than any other stock or mutual fund with a history of more than 30 years, and Berkshire has a significant alpha to traditional risk factors. However, we find that the alpha becomes insignificant when controlling for exposures to Betting-Against-Beta and Quality-Minus-Junk factors. Further, we estimate that Buffett’s leverage is about 1.6-to-1 on average. Buffett’s returns appear to be neither luck nor magic, but, rather, reward for the use of leverage combined with a focus on cheap, safe, quality stocks. Decomposing Berkshires’ portfolio into ownership in publicly traded stocks versus wholly-owned private companies, we find that the former performs the best, suggesting that Buffett’s returns are more due to stock selection than to his effect on management. These results have broad implications for market efficiency and the implementability of academic factors

Fonte: Andrea Frazzini, David Kabiller & Lasse Heje Pedersen (2018) Buffett’s Alpha,Financial Analysts Journal, 74:4, 35-55, DOI: 10.2469/faj.v74.n4.3